어도비시스템즈는 2016년 음성 합성 기술 ‘보코(VoCo)’를 공개했지만 아직까지 정식 출시하지는 않고 있다.

영화 <미션 임파서블>의 마스크 기계는 언제 봐도 놀랍다. 스캐너로 복제할 사람 얼굴을 스캔하면 3차원(3D) 프린터가 몇 분 안에 똑같은 얼굴을 찍어낸다. 얼굴 뿐인가. 말 몇 마디 들려주면 목소리도 똑같이 만들어낸다. 마스크를 쓰고 음성변조 칩을 목에 붙이면 영락없이 똑같은 사람이 복제된다. 사람 눈과 귀로는 진짜와 가짜 구분이 사실상 불가능하다. ‘딥페이크’는 이미 26년 전부터 이 영화의 ‘시그니처’였다.

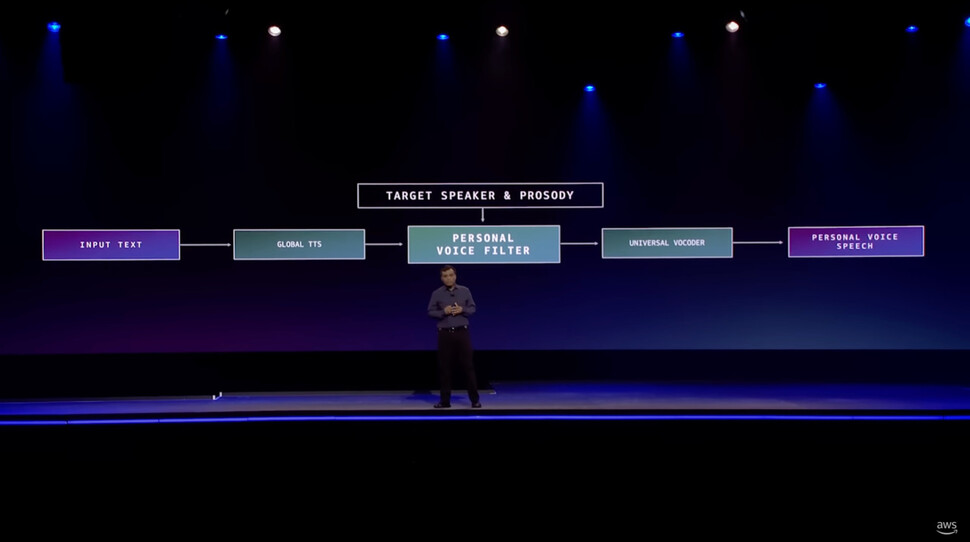

기술 발전이 언제든 복제본을 소환하는 세상은 어떤 모습일까. 아마존의 인공지능(AI) 음성 비서 ‘알렉사’가 이런 일로 입길에 올랐다. 지난 6월22일 미국 라스베이거스에서 열린

‘리마스’ 컨퍼런스에서 선보인 기능 때문이다. 이날 아마존은 알렉사가 고인이 된 할머니 목소리로 아이에게 동화책을 읽어주는 동영상을 보여줬다. 아마존 설명대로라면, 1분 남짓한 음성 표본만 있으면 알렉사는 그 목소리를 그대로 복제해 흉내낼 수 있다.

아마존이 6월22일 개최한 ‘리마스(re:MARS)’ 컨퍼런스에서 고인의 목소리를 재현하는 ‘알렉사’의 새로운 기능을 소개하고 있다.

할머니가 손주에게 동화를 도란도란 들려주는 풍경은 정겹지만, 고인이라면 얘기가 다르다. 숨진 가족을 인공지능이 현실로 소환하는 건 반가우면서도 오싹한 일이다. 당장 언론이 들썩거렸다. ‘섬뜩하다’, ‘윤리', ‘악용' 같은 단어들이

지면을 채웠다. <워싱턴포스트>는 보안 전문가 말을 빌려 “사기와 데이터 탈취, 계정 도용 등으로 이어질 수 있다”고

지적했다.

왜 새삼 호들갑일까. 인공지능이 사람을 투사하는 현상은 낯선 풍경이 아니다. 검색창에 ‘AI audio clone’을 넣어보자. 온갖 목소리 복제 프로그램이 쏟아진다. 소스코드가 공개돼 누구나 가져다 쓸 수 있는 프로그램도 널렸다. 복잡한 기술을 몰라도 누구든 마음만 먹으면 진짜 같은 가짜를 만들 수 있다.

‘포토샵’으로 유명한 어도비시스템즈는 2016년 개발자 행사에서 ‘프로젝트 보코(VoCo)’를 공개했다. 20분 분량의 연설을 녹음하면 이를 학습해 그 사람의 목소리를 재현해내는 인공지능 합성 기술이다. 보코는 ‘오디오 포토샵’으로 불리며 큰 관심을 모았다. 어도비는 이 기술이 오디오 제작 비용을 낮추는 데 기여할 것이라고 말했지만, 당시에도 이 기술이 사기나 범죄에 악용될 수 있다는 경고 목소리가 높았다. 이 기술은 6년이 지난 지금도 상용화되지 않고 있다.

카카오는 2015년, 미디어다음 JTBC 뉴스룸 ‘앵커브리핑’에서 손석희 앵커가 직접 단 댓글을 실제 말투와 목소리를 합성한 인공지능 음성으로 읽어주는 서비스를 선보였다. 10시간 분량의 기존 방송 데이터를 기반으로 인공지능이 합성을 거쳐 손석희 앵커 목소리를 진짜처럼 재현해냈다. 이를 보고 놀라고 신기해하는 사람은 여럿 봤지만, 섬뜩하거나 오싹하다는 반응은 듣지 못했다.

익숙하다고 해서 문제가 없는 건 아니다. 우리는 진짜 같은 가짜엔 익숙하지만, 이를 받아들일 준비는 아직 안 됐다. 그러니 기술에 놀라는 만큼 부작용을 우려하는 목소리도 반복된다.

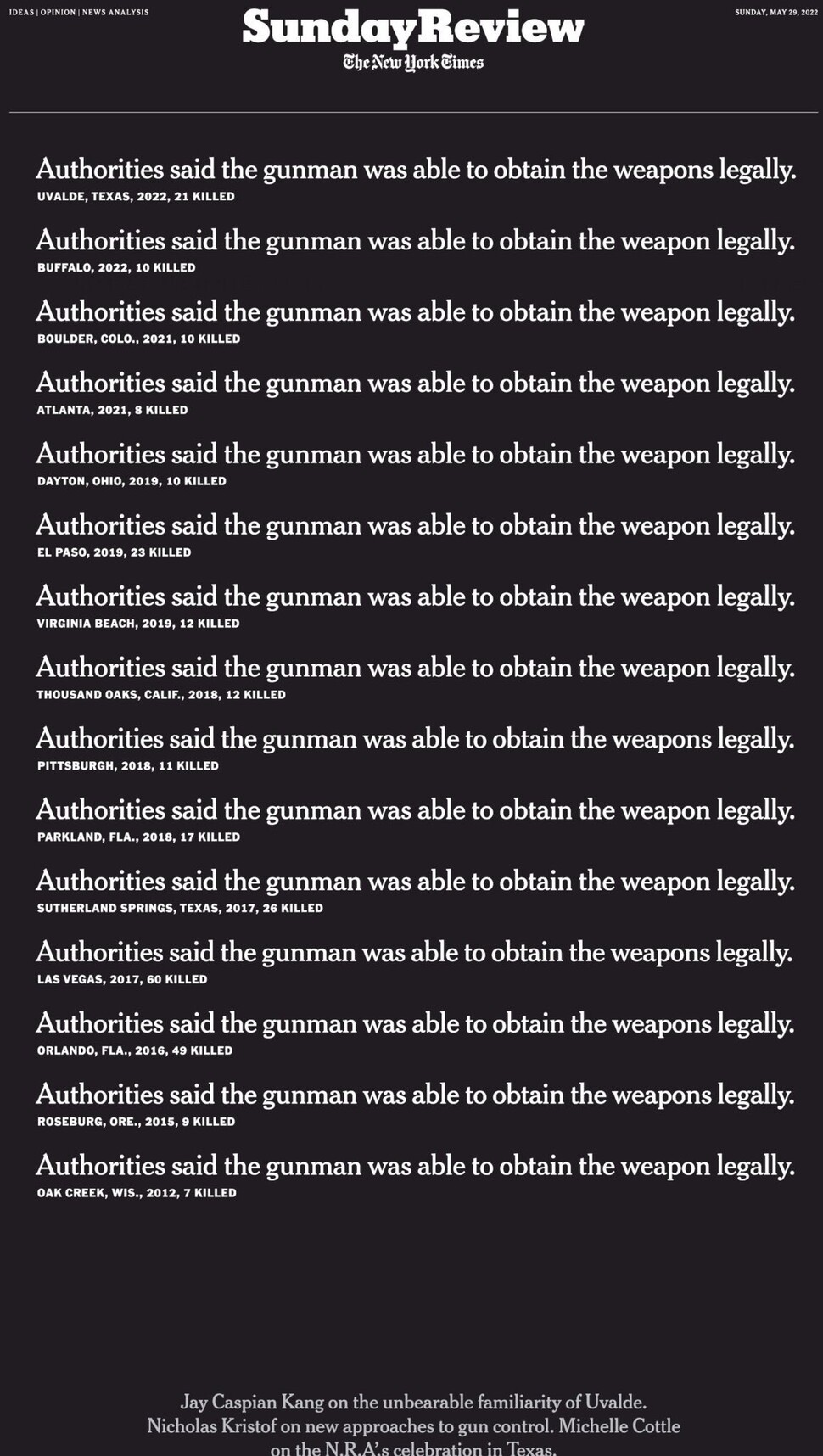

미국 텍사스 초등학교 총기 사고가 난 직후, <뉴욕타임스> 5월29일자 선데이리뷰 1면은 똑같은 헤드라인 15개를 반복해 나열했다. “당국은 범인이 총기를 합법적으로 소유할 수 있었다고 말했다.” 2012년부터 10년 동안 총기 사고가 날 때마다 토씨 하나 안 틀리고 반복된 ‘변명’을 꼬집은 것이다.

뉴욕타임스 5월29일자 선데이리뷰 1면. 수십년 동안 끔찍한 총기사고가 이어짐에도 같은 지적만 되풀이하는 현실을 지적하고 있다.

진짜와 가짜가 공존하는 세상은 이미 와 있다. 부정할 수 없는 현실이다. 머잖아 진짜와 가짜의 구분마저 무의미해질 지도 모른다. 부작용을 우려해 막을 생각부터 할 게 아니라, 현명하게 제어하고 활용할 방안을 모색하는 데 집중하자. 머잖아 더욱 정교해진 가짜가 나왔을 때 또다시 ‘섬뜩’해하고 호들갑 떨지 않기 위해.

이희욱 미디어전략팀장

asadal@hani.co.kr

![[사설] 노동자 안전 뒷전 중대재해법 후퇴가 민생 대책인가 [사설] 노동자 안전 뒷전 중대재해법 후퇴가 민생 대책인가](http://flexible.img.hani.co.kr/flexible/normal/300/180/imgdb/child/2024/0116/53_17053980971276_20240116503438.jpg)

![[올해의 책] 숙제를 풀 실마리를 찾아, 다시 책으로 ①국내서 [올해의 책] 숙제를 풀 실마리를 찾아, 다시 책으로 ①국내서](http://flexible.img.hani.co.kr/flexible/normal/800/320/imgdb/original/2023/1228/20231228503768.jpg)

![[올해의 책] 숙제를 풀 실마리를 찾아, 다시 책으로 ②번역서 [올해의 책] 숙제를 풀 실마리를 찾아, 다시 책으로 ②번역서](http://flexible.img.hani.co.kr/flexible/normal/500/300/imgdb/original/2023/1228/20231228503807.jpg)

![오세훈발 ‘토허제 해제’ 기대감…서울 아파트 또 오르나요? [집문집답] 오세훈발 ‘토허제 해제’ 기대감…서울 아파트 또 오르나요? [집문집답]](http://flexible.img.hani.co.kr/flexible/normal/212/127/imgdb/original/2025/0211/20250211501041.webp)