챗봇을 과학논문 저자로 등재하는 것이 적절한지를 두고 해외 과학출판계에서 논란이 일고 있다. 위키미디어코먼스

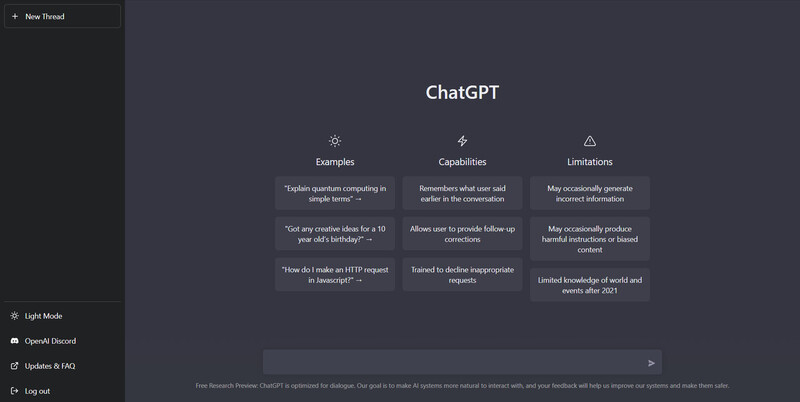

미국의 인공지능 개발업체 ‘오픈에이아이’(Open AI)가 지난해 11월 내놓은 인공지능 챗봇 ‘챗지피티’(ChatGPT)가 전문 분야에서도 놀라운 능력을 발휘하고 있다.

미국의사면허시험(USMLE)에서 치르는 3가지 시험에서 모두 합격점을 통과하거나 그에 준하는 실력을 보여주는가 하면, 챗지피티가 짜깁기한 논문 초록을 전문가들의 3분의 1이 몰라보는 일도 일어났다. 아예 챗지피티를 공동저자로 등재한 과학 논문까지 잇따르고 있다. 이에 따라 챗봇을 논문 저자로 등재하는 것이 적절한지를 두고 해외 과학출판계에서 논란이 일고 있다.

챗지피티는 인터넷에서 수집한 방대한 문서 자료를 토대로 설득력 있는 문장을 생성하는 대규모 언어 모델(LLM)이다.

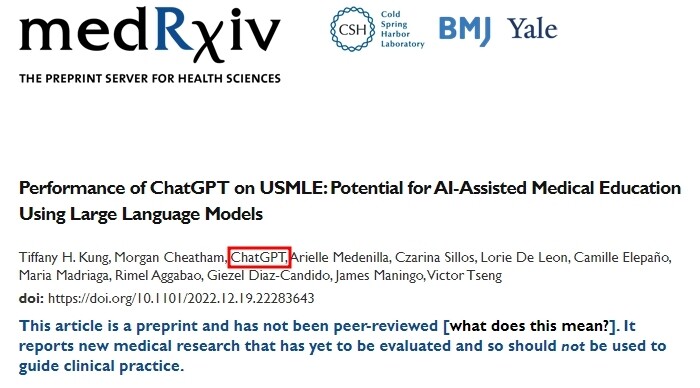

국제학술지 ‘네이처’ 뉴스팀에 따르면 지금까지 최소 4건의 출판논문과 사전출판논문에 저자로 이름을 올렸다. 예컨대 지난해 12월19일 의학 부문 사전출판논문 저장소 ‘메드아카이브’( medRxiv)에 게재된 ‘미국의사면허시험에서의 챗지피티 성능’이란 제목의 논문에는 챗지피티가 12명의 저자 명단에 포함돼 있다.

저널 ‘간호교육실무’(Nurse Education in Practice) 2023년 1월호의 사설도 인공지능을 시오반 오코너 맨체스터대 교수와 함께 공동저자로 올려놨다. 그러나 이 저널의 편집장은 이는 실수로 잘못 나간 것이며 곧 정정할 것이라고 네이처에 밝혔다. 그는 “사설은 연구 논문과 다른 관리 시스템을 거치기 때문에 그건 전적으로 나의 실수였다”고 말했다.

인공지능을 이용해 약물을 개발하는 홍콩 기업 인실리코 메디슨의 알렉스 자보론코프 대표는 지난달 저널 ‘온코사이언스’(Oncoscience)에 게재한 논문에 챗지피티를 공동저자로 올렸다. 이 논문은 ‘파스칼의 내기’라고 불리는 철학적 맥락에서 면역억제제 라파마이신 복용의 장단점을 논하는 내용이다. 그는 그동안 생성형 인공지능 도구를 이용해 80편 이상의 논문을 완성해 발표했다고 말했다. 그는 저널쪽이 자신의 요청에 따라 이 논문에 대한 동료학자들의 검토를 거쳤다고 덧붙였다.

지피티3를 공저자로 올린 또다른 논문은 지난해 6월 프랑스의 사전출판논문 저장소 ‘할’(HAL)에 실린 데 이어 곧 동료 검토 저널에도 게재될 예정이다. 공저자인 스웨덴 예테보리대학병원의 알미라 오스마노비치 툰스트룀(신경생물학)은 첫번째 저널은 검토 후 논문 게재를 거절했으나 두번째 저널은 검토자의 요청에 따라 논문을 다시 작성해 내자 지피티3를 저자로 인정했다고 전했다.

챗지피티(빨간색 네모)를 논문 공저자로 등재한 사례.

일단 ‘네이처’와 접촉한 편집장이나 발행인들은 챗지피티같은 인공지능은 저자의 기준을 충족하지 못한다는 입장을 표명했다. 인공지능은 과학 논문의 내용과 진실성에 대한 책임을 질 수 없다는 게 주된 이유였다. 그러나 일부 발행인은 저자 명단이 아닌 다른 영역에서는 인공지능의 논문 기여를 인정할 수 있다는 입장이다.

뉴욕 콜드스프링하버연구소 출판부의 리처드 시버 부소장은 “학술 원고 저자라는 역할과 문서 작성자로서의 저자라는 좀 더 일반적인 개념을 구분할 필요가 있다”는 입장을 밝혔다. 저자는 자신의 연구 작업에 대한 책임을 져야 하기 때문에 사람만이 저자로 등재돼야 한다는 것이다.

저명한 국제학술지 ‘네이처’와 ‘사이언스’ 편집장도 챗지피티가 저자 기준에 부합하지 않는다는 견해를 밝혔다. ‘네이처’ 편집장 막달레나 스키퍼는 “저자 표시는 연구 작업에 대한 책임을 수반하는데, 이를 대규모 언어모델(LLM)에 적용할 수는 없다”고 말했다. 그는 대신 “논문을 쓰는 과정에서 어떤 식으로든 대규모 언어모델을 사용한 저자는 필요할 경우 감사의 글을 포함한 적절한 방법으로 그 내용을 기록으로 남겨야 한다”고 말했다.

‘사이언스’ 편집장 홀든 소프는 ‘사이언스’가 출판하는 논문에서 인공지능을 저자로 올리는 것을 허용하지 않을 것이라고 밝혔다. 그는 적절한 인용 없이 인공지능이 생성한 문구를 사용하는 것은 표절로 간주될 수 있다고 덧붙였다.

물리학 사전출판논문 저장소인 ‘아카이브’(arXiv) 이사회도 내부 논의를 거쳐 현재 생성 인공지능의 사용을 어떻게 처리할지에 관한 의견을 수렴하고 있다고 ‘네이처’는 전했다. 이사회의 일원인 스테인 시거드슨(천문학) 펜실베이니아대 교수는 소프트웨어는 사용 약관과 내용 배포 권한에 대한 동의 여부를 결정할 수 없다는 점에서 저자가 될 수 없다고 말했다.

“인공지능 오용 문제, 학계의 골칫거리 될 것”

영국 연구진실성관리국의 매트 홋킨슨 매니저는 개인 의견임을 전제로, 챗지피티가 공동 저자로 인정되어서는 안 되는 저자 지침이 이미 명확하게 존재한다고 ‘네이처’에 말했다.

그에 따르면 제1의 저자 지침은 ‘공동저자는 기사에 중요한 학술적 기여를 해야 한다’는 것이다. 이는 챗지피티 같은 도구도 가능한 일이다. 그러나 또 하나의 저자 지침이 있다. 공동저자가 되는 데 동의할 수 있어야 할 뿐더러 자신의 연구 또는 적어도 기여 부분에 대한 책임을 질 수 있어야 한다는 것이다. 그는 이 부분에서 인공지능에 공동저자 지위를 부여하는 것이 벽에 부딪힌다고 말했다.

인실리코의 자보론코프 대표는 자신의 챗지피티 사용 경험을 들어 좀 더 현실적인 문제를 제기했다. 그는 챗지피티를 이용해 자신이 게시한 관점보다 더 기술적인 논문을 작성하도록 시도했지만 실패했다고 한다. 챗지피티가 사실이 아닌 내용을 내놓는 경우가 매우 많았으며, 같은 질문을 여러 번 묻자 다른 답변을 내놓았다는 것이다.

그는 앞으로 해당 분야 전문 지식이 없는 사람들도 인공지능의 힘을 빌어 과학 논문을 작성하려고 시도가 나올 수 있다는 점을 들어 인공지능 시스템 오용 문제가 학계의 골칫거리가 될 것이 분명하다고 우려했다.

‘네이처’는 논란이 불거지자 독자들을 대상으로 긴급 설문조사를 벌였다. 그 결과 응답자 3600명의 58%가 학술 논문 작성에 챗지피티 같은 생성 인공지능을 사용해선 안된다고 답변했다. ‘네이처’는 다수의 응답자가 챗봇이 위조되고 부정확한 문서를 쉽게 만들 수 있기 때문에 이를 판별해낼 수 있는 시스템이 있을 때까지 사용을 금지하는 것이 가장 좋다는 의견을 냈다고 밝혔다.

곽노필 선임기자

nopil@hani.co.kr

![[사설] 노동자 안전 뒷전 중대재해법 후퇴가 민생 대책인가 [사설] 노동자 안전 뒷전 중대재해법 후퇴가 민생 대책인가](http://flexible.img.hani.co.kr/flexible/normal/300/180/imgdb/child/2024/0116/53_17053980971276_20240116503438.jpg)

![[올해의 책] 숙제를 풀 실마리를 찾아, 다시 책으로 ①국내서 [올해의 책] 숙제를 풀 실마리를 찾아, 다시 책으로 ①국내서](http://flexible.img.hani.co.kr/flexible/normal/800/320/imgdb/original/2023/1228/20231228503768.jpg)

![[올해의 책] 숙제를 풀 실마리를 찾아, 다시 책으로 ②번역서 [올해의 책] 숙제를 풀 실마리를 찾아, 다시 책으로 ②번역서](http://flexible.img.hani.co.kr/flexible/normal/500/300/imgdb/original/2023/1228/20231228503807.jpg)